Verifica le date inserite: la data di inizio deve precedere quella di fine

Sara Benaglia

Leggi i suoi articoliNel corpo architettonico del MuFoCo, un’intelligenza dormiente si attiva. «Animati. God, Human, Animal, Machine» non è una mostra, ma una sorta di codice curatoriale incarnato: un campo semantico in collisione, dove filosofia e deep learning si confrontano come alleati instabili. Curata da Chiara Bardelli Nonino, Features Director di Harper’s Bazaar Italia, insieme a Giacomo Mercuriali e Emanuele Amighetti, «Animati» mostra fotografie dopo aver messo in crisi il processo di selezione umana delle immagini, essenziale fino ad oggi per la costituzione di una collezione museale.

L’impulso iniziale (chiamiamolo desiderio poetico) è di Davide Rondoni, presidente del museo, che lancia una domanda arcaica in un sistema digitale: che cos’è l’umano? Da qui nasce un rituale curatoriale ibrido, che intreccia lo sguardo umano con quello statistico. Il patrimonio fotografico del museo diventa linguaggio per una macchina: un database interrogato da Clip, rete neurale di OpenAI addestrata a riconoscere affinità semantiche tra immagini e parole, non per comprenderle, ma per farle collassare nello stesso spazio latente.

Clip-Contrastive Language Image Pretraining è una macchina oracolare allenata su 400 milioni di coppie immagine-testo raccolte online. Funziona con una doppia architettura: una rete codifica il linguaggio in vettori, un’altra le immagini. I loro output si incontrano in uno spazio latente condiviso: un campo gravitazionale dove i significati non si spiegano, ma si attraggono. Non interpreta categorie visive concrete come «gatto», ma misura quanto concetti astratti come «anima» vibrano con un’immagine. È lì che la mostra ha agito: proponendo alla macchina parole che ci interrogano più di quanto possiamo definirle.

La curatrice ha digitato parole come «anima», «coscienza», «nascita», ma le ha prima filtrate attraverso il prisma concettuale di Meghan O’Gieblyn («God», «Human», «Animal», «Machine»), quasi volesse inoculare un pensiero metafisico in una rete che non sa cosa sia il sacro. Clip non capisce. Ma osserva. Confronta. Misura. Sono state scandagliate 12mila immagini dall’archivio MuFoCo che, secondo la sua logica vettoriale, ha risposto. Il risultato è un atlante di somiglianze numeriche: pattern visivi che galleggiano accanto ai concetti richiesti, in quello spazio latente dove la parola «soul» è solo una coordinata tra milioni. Clip è uno strumento pragmatico, nato per sorvegliare, non per contemplare. Un occhio statistico cieco ai simboli, ma preciso nelle correlazioni. È stato progettato per vedere senza comprendere. Eppure, lo abbiamo interrogato come se potesse sognare.

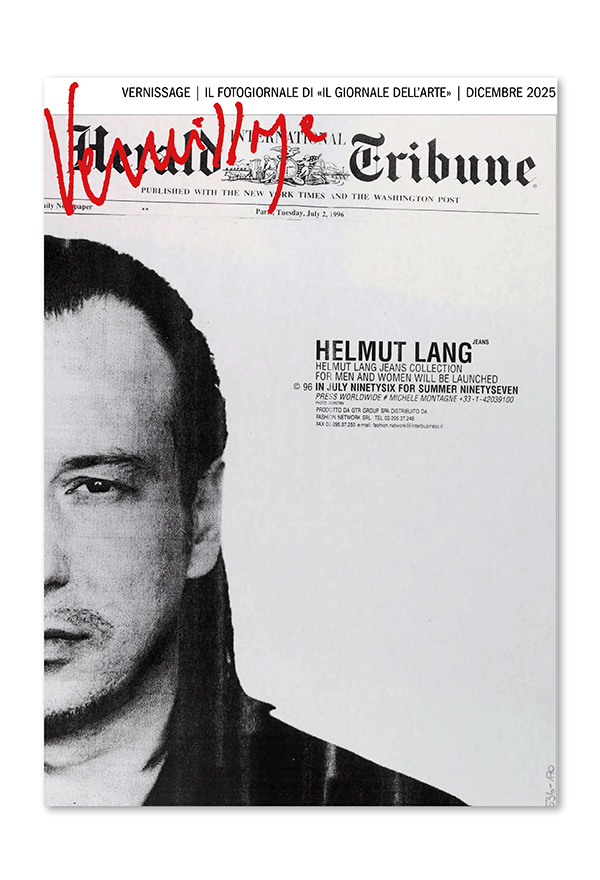

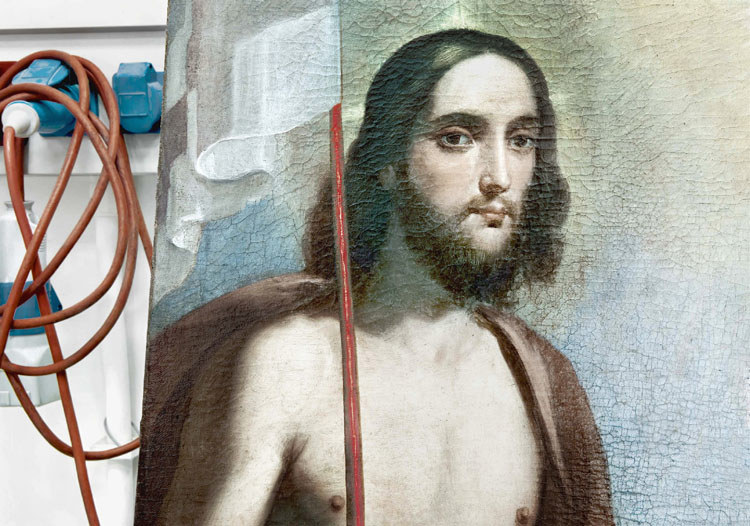

Mario Cresci, «La cura, Matera, laboratorio di restauro», dalla serie «Forse Fotografia, Attraverso l’umano», 2011. © Mario Cresci - Museo di Fotografia Contemporanea, Milano-Cinisello Balsamo

Mimmo Jodice, «Bruciatura», 1977. © Mimmo Jodice - Regione Lombardia / Museo di Fotografia Contemporanea, Milano-Cinisello Balsamo

Un’interfaccia sviluppata da Giacomo Mercuriali ha ordinato le risposte in una lista per pertinenza, dal centro semantico al glitch. Ma l’ultima parola è rimasta umana. Chiara Bardelli Nonino ha attraversato questo flusso numerico con uno sguardo bifronte: affidandosi, e allo stesso tempo resistendo. Alcune immagini sembrano incarnare fedelmente la parola interrogata. Altre, come una banana in risposta a «anima», disorientano. Generano cortocircuiti di significato, poetiche senza autore. È lì, nel fallimento, che qualcosa accade: uno spazio per la domanda, per l’errore fertile, per l’umano che ricompone ciò che l’algoritmo disgrega.

L’allestimento di Emanuele Amighetti parla il linguaggio visivo dell’epoca algoritmica: superfici pulite, assenza di contesto, flusso interrotto. È un ambiente computazionale travestito da esposizione. Le fotografie (76 voci archiviate in pixel e polvere ottica, da Basilico a Plossu) fluttuano senza didascalie, sottratte alla narrazione e restituite all’indeterminatezza. Le parole che le hanno generate, le «query» che hanno scatenato l’atto selettivo, sono dislocate: murali, epigrafi periferiche, coordinate vaghe. Tocca a chi guarda comporre i frammenti. Come se si scorresse un feed in un museo senza tempo.

Entrare in «Animati» è come accedere a un’interfaccia rallentata: un «feed» disteso nello spazio fisico, una dilatazione percettiva dello «scroll». Il gesto è lo stesso (scorrere, dimenticare, passare oltre), ma qualcosa resiste. Le cornici interrompono il gesto fluido, come insetti che pungono nel sonno digitale. Costringono a sostare. Eppure, l’autore è evaporato, come nei social: nessuna firma, nessuna biografia a guidare lo sguardo. Cosa significa, oggi, sostare davanti a un’immagine? Guardarla senza passare oltre? Che significato ha «guardare» nello spazio latente? Che corpo costruisce un museo quando lo spazio espositivo simula un algoritmo?

«Animati» vive un paradosso: parlare dell’umano con una macchina che umana non è. L’IA non pensa, ma genera. Trasforma concetti in coordinate, coscienza in calcolo. Diventa coautrice in un discorso che non può comprendere. Un agente cieco che riorganizza «anima», «morte», «famiglia» come dati logistici. Ne nasce un’estetica dell’errore: immagini che evocano senso e contemporaneamente lo negano. Un glitch che si traveste da intuizione. Un algoritmo che recita, senza sapere, una poesia sbagliata.

MuFoCo non si limita ad accogliere questa sfida: la lascia detonare. Si fa laboratorio di un nuovo rapporto tra archivio e macchina. L’installazione di Giacomo Mercuriali spinge questo gesto oltre: immagini generate da AI secondo lo «stile MuFoCo» si dispongono come echi disturbanti la memoria istituzionale. È una cartografia della somiglianza, un soggetto sintetico che simula il museo. Usare Clip per curare è come puntare un telescopio sul vuoto per scrivere versi: qualcosa può emergere, ma il poeta resta altrove.

L’intelligenza artificiale si impone come nuovo medium della soggettività, o del suo simulacro. Riflette, ma non sente. Organizza, ma non interpreta. È addestrata su desideri e pregiudizi umani, che riformula come pattern. In «Animati», questa deriva è stata trasmutata in invocazione. L’archivio non è più specchio, ma soglia: uno spazio per immaginare cosa l’immagine, e forse l’umano, stanno diventando.